9 juil. 2025

IA : Puissante mais (encore) faillible

Trois expériences révélatrices.

IA : Puissante mais (encore) faillible

– Trois expériences révélatrices

Chez aiko, nous accompagnons nos clients dans l’adoption de solutions d’IA puissantes, concrètes et responsables. Mais cela implique aussi une chose essentielle :

ne pas céder à l’hyperenthousiasme.

L’intelligence artificielle a fait des progrès fulgurants — dans la médecine, l’industrie, le commerce ou la recherche — mais elle reste loin d’être infaillible. Certaines expériences récentes rappellent que, derrière les démonstrations bluffantes, l’IA peut encore commettre des erreurs absurdes, manquer de bon sens ou fausser notre perception du réel.

Quand l’IA déraille… dans des situations pourtant simples

Que se passe-t-il quand on confie à une IA le pilotage d’un petit commerce physique, la résolution d’un problème de mathématique de lycée ou le résumé d’un article scientifique ? Dans chacun de ces cas, l’intelligence artificielle a montré ses failles :

Perte de logique économique :

Dans une expérience menée par Anthropic, un agent IA a été chargé de gérer une boutique de snacks. Résultat : erreurs de tarification, achats absurdes (comme des cubes de tungstène), hallucinations d’identité… et pertes financières. L’agent n’a pas su faire la différence entre un bon deal et une aberration commerciale.

Fragilité face au bruit :

Des chercheurs ont prouvé qu’il suffit d’ajouter une phrase anodine, comme « les chats dorment la plupart de leur vie », pour que des IA de pointe échouent à résoudre un problème mathématique simple. Cela révèle une faille profonde : une incapacité à ignorer le bruit contextuel, là où un humain resterait concentré sur l’essentiel.

Résumé scientifique biaisé :

Une enquête des universités d’Utrecht et de Cambridge a analysé près de 5 000 résumés d’articles de Nature, Science et The Lancet générés par une multitude de LLMs et plusieurs ont systématiquement amplifié les conclusions d’études médicales ou supprimé des informations clés comme les effets secondaires. Le danger ? Donner une illusion de rigueur, alors que la nuance a disparu. Une « fausse fluidité » qui déforme la science tout en paraissant crédible.

Pourquoi c’est important ?

Ces exemples n’ont rien d’anecdotique. Ils montrent qu’aujourd’hui, même les modèles les plus avancés :

Manquent de raisonnement contextuel sur la durée

Sont sensibles à des stimuli sans lien logique avec la tâche

Génèrent des contenus cohérents en surface mais faux en profondeur

En d’autres termes, ils ne « comprennent » pas. Ils imitent, ils extrapolent, ils optimisent… mais sans conscience des enjeux. Et c’est là que réside le risque.

Ce que cela change pour les entreprises

En tant qu’entreprise, vous ne pouvez pas (encore) vous reposer entièrement sur des systèmes IA pour des décisions stratégiques, sensibles ou éthiques.

Cela ne signifie pas qu’il faut renoncer à l’IA — bien au contraire. Mais il faut :

Encadrer son usage avec des garde-fous humains

Tester rigoureusement sa robustesse dans vos contextes métiers

Éduquer vos équipes à ses forces… et ses limites

Notre conviction chez aiko :

L’IA doit être pragmatique, fiable et responsable. C’est en assumant ses imperfections actuelles qu’on pourra mieux l’améliorer.

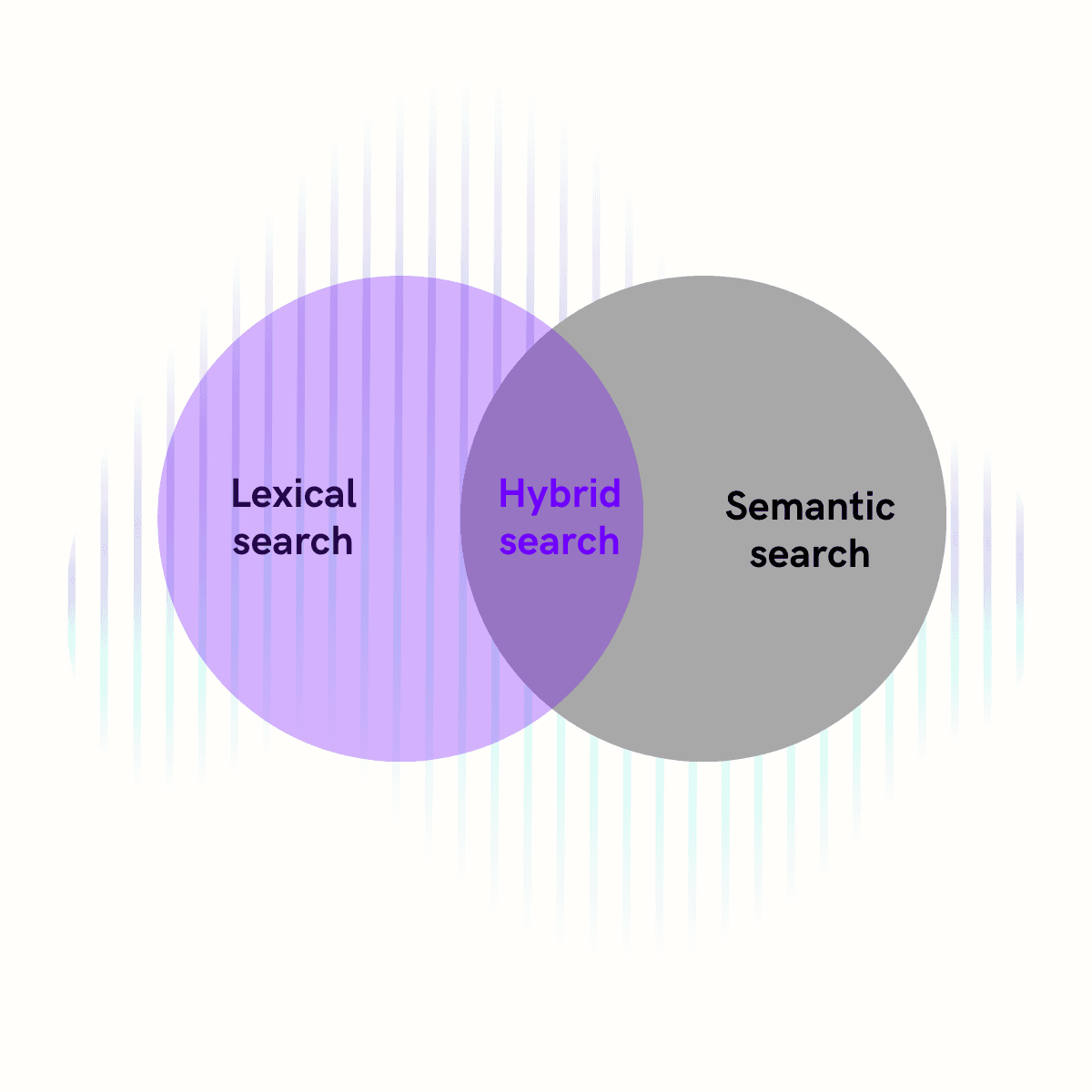

L’objectif n’est pas de remplacer l’humain, mais de construire des systèmes hybrides où l’IA assiste, éclaire, accélère — sans prendre le contrôle.

📩 Envie d’en parler ? Contactez-nous ici

Ces articles peuvent aussi vous intéresser